Biến Mac Mini Thành Trợ Lý AI Cá Nhân Với DeepSeek R1, Open WebUI và Ollama

Biến Mac Mini Thành Trợ Lý AI Cá Nhân Với DeepSeek R1, Open WebUI và Ollama

Tại Sao Chạy AI Cục Bộ Lại Ngầu?

Mình đang phê pha với việc biến con Mac Mini M4 cùi bắp thành một cỗ máy AI cá nhân thực thụ. Chạy AI cục bộ nó “phê” ở chỗ:

- API “chùa”: Hoàn toàn làm chủ AI của bạn, không lo giới hạn từ bên thứ ba.

- Không cần “lên mây”: Dữ liệu riêng tư, AI chạy ngay trên máy tính của bạn.

- Tốc độ “bàn thờ”: Tận dụng sức mạnh GPU, tùy chỉnh để đạt hiệu suất tối đa.

- Giao diện “chanh sả” như ChatGPT: Open WebUI biến AI thành chatbot hiện đại, tạm biệt dòng lệnh khô khan.

- Khả năng “biến hình vô cực”: Tinh chỉnh mô hình, tạo tác vụ riêng, tùy biến theo nhu cầu.

Nói tóm lại, nếu bạn muốn làm chủ AI thực sự, thì đây là cách “hack” để biến con máy tính của mình thành cỗ máy AI cá nhân.

Mac Mini + DeepSeek: Cặp Đôi Hoàn Hảo?

Mình đang dùng con Mac Mini M4 để chạy AI “tẹt ga” từ xử lý văn bản, hình ảnh đến suy luận “hack não”. Quên hết mấy cái đám mây lằng nhằng đi.

Con máy này có 24GB RAM, GPU 10 nhân với con chip M4, đủ sức “gánh” mấy tác vụ AI. Nhưng có một vấn đề là cái giao diện terminal nó “củ chuối” quá. Không có gợi ý, không lưu lịch sử chat, nhìn chỉ muốn đấm cho phát chết tươi.

Đấy là lúc Docker và Open WebUI xuất hiện. Chúng biến cái terminal “ghẻ lở” thành giao diện “chanh sả” như ChatGPT, chat chit mượt mà, lưu trữ lịch sử đầy đủ, lại còn “mix” được nhiều mô hình khác nhau nữa chứ.

Quan trọng: Mình không dùng API của DeepSeek. Mình đang “quẩy” con DeepSeek R1 cục bộ bằng llama.cpp (hoặc Ollama) mà không phụ thuộc vào bất kỳ API đám mây nào.

DeepSeek là gì? “Món quà” cho thường dân, “cú đấm” vào mặt Big Tech

Chạy DeepSeek Cục Bộ: “Cân Đo Đong Đếm” Phần Cứng

DeepSeek R1 có đủ loại “size” cho bạn lựa chọn, từ bé tí đến “khổng lồ”. Mô hình càng to thì càng thông minh, nhưng cũng “ngốn” phần cứng hơn.

| Mô Hình | RAM Cần Thiết | CPU Yêu Cầu | Cần GPU? | ”Gu” Sử Dụng Phù Hợp |

|---|---|---|---|---|

| 1.5B | 8GB+ | CPU đời mới | ❌ | Viết lách cơ bản, chat “nhanh như điện” |

| 8B | 16GB+ | 4+ nhân (Intel i5/Ryzen 5/M1) | ❌ | Suy luận chung, viết dài, code dạo |

| 14B | 24GB+ | 6+ nhân (Intel i7/Ryzen 7/M2) | ❌ | Suy luận sâu, code “khó nhằn”, nghiên cứu |

| 32B | 32-64GB+ | 8+ nhân (M3 Pro, Ryzen 9, i9) | ✔️ | Giải quyết vấn đề “hack não”, code AI |

| 70B | 64GB+ | 12+ nhân (M4 Pro, Threadripper) | ✔️ | ”Quẩy” quy trình AI nặng đô, nghiên cứu “pro” |

| 70B Vision | 64GB+ | 12+ nhân (M4 Pro, Threadripper) | ✔️ | ”Mổ xẻ” ảnh, tạo ảnh AI |

| 1.671B | 512GB+ | 128+ nhân (Chỉ dành cho server) | Phải có nhiều GPU | ”Đấm” nhau với siêu máy tính |

Chọn “size” nào là tùy vào “cơ bắp” con máy của bạn.

”Mì Ăn Liền” Chạy DeepSeek: Nhanh, Dễ, “Í ẹ”!

Nếu bạn muốn “test” nhanh, thì đây là cách “mì ăn liền” để chạy DeepSeek trên terminal:

Hướng dẫn “Mì Ăn Liền”:

Bước 1: “Tải” Ollama (công cụ AI)

/bin/bash -c "$(curl -fsSL https://ollama.com/download)"Kiểm tra xem đã “tải” xong chưa:

ollama --versionBước 2: “Kéo” DeepSeek R1 Về (Chọn “Size”)

Chọn “size” DeepSeek R1 dựa trên phần cứng của bạn:

ollama pull deepseek-r1:8b # "Size" nhỏ nhất, chạy nhanh nhất

ollama pull deepseek-r1:14b # Cân bằng giữa tốc độ và hiệu năng

ollama pull deepseek-r1:32b # "Size" trung bình, hiệu năng ổn

ollama pull deepseek-r1:70b # "Size" to nhất, chạy chậm nhấtBước 3: “Quẩy” DeepSeek R1 (Chế Độ Cơ Bản)

Để “test” mô hình trong terminal (chạy tạm thời):

ollama run deepseek-r1:14bCách này thì chạy được đấy, nhưng nó “trần trụi” như dùng ChatGPT từ đời “Tống”.

Giờ mình sẽ “độ” cho nó “ngon” hơn để dùng hàng ngày.

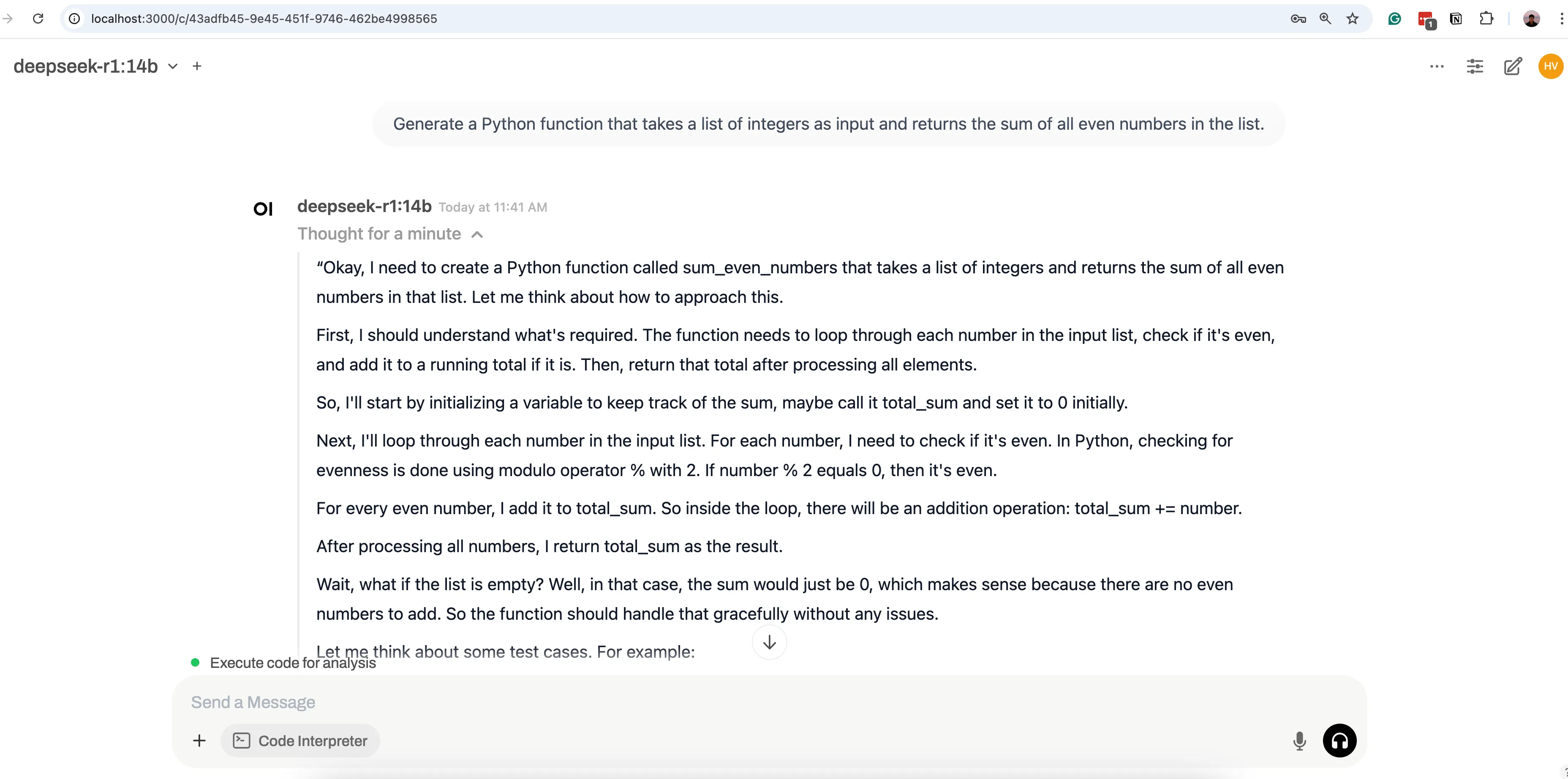

”Độ” Giao Diện ChatGPT Cho DeepSeek Bằng Docker và Open WebUI

Giờ DeepSeek R1 đã “nằm” trong máy, mình sẽ “thay áo” cho nó bằng Docker + Open WebUI để có giao diện chat “xịn sò” như ChatGPT.

”Tải” Docker (Cần Để Chạy Open WebUI)

Docker giúp chạy Open WebUI, biến cái terminal “ghẻ lở” thành giao diện chat “mượt như nhung”.

- Truy cập https://www.docker.com/get-started.

- “Tải” Docker Desktop cho macOS.

- Mở Docker (để chạy ngầm).

Giờ thì “triển” Open WebUI thôi.

”Cài” Open WebUI (ChatGPT Của Riêng Bạn)

Chạy lệnh này trong Terminal:

docker run -d --rm -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:mainLệnh này “hack não” ở chỗ:

- “Cài” Open WebUI.

- “Bật” server tại

http://localhost:3000. - Chạy ngầm.

- Tự động xoá container khi tắt.

Tiếp theo mở Chrome lên và “gõ”:

http://localhost:3000

“Done”! Giờ bạn đã có AI kiểu ChatGPT chạy “tẹt ga” trên máy của mình!

Kết nối Open WebUI với DeepSeek R1 và bạn có ngay giao diện chat “xịn sò”.

Để tắt Open WebUI, bạn có thể dừng container webui

docker stop open-webuiChào mừng bạn đến với HocCodeAI 👋

Hãy ghé thăm trang chủ hoccodeai.com để khám phá thêm nhiều bài viết hữu ích.

Nhớ xem thử khóa học Generative AI của bọn mình để nâng cao kỹ năng của bạn nhé!